Ανεξέλεγκτη δύναμη αποκτά η τεχνητή νοημοσύνη

Άρθρο - έκκληση στους FT: Χαμηλώστε ταχύτητα στην Τεχνητή Νοημοσύνη

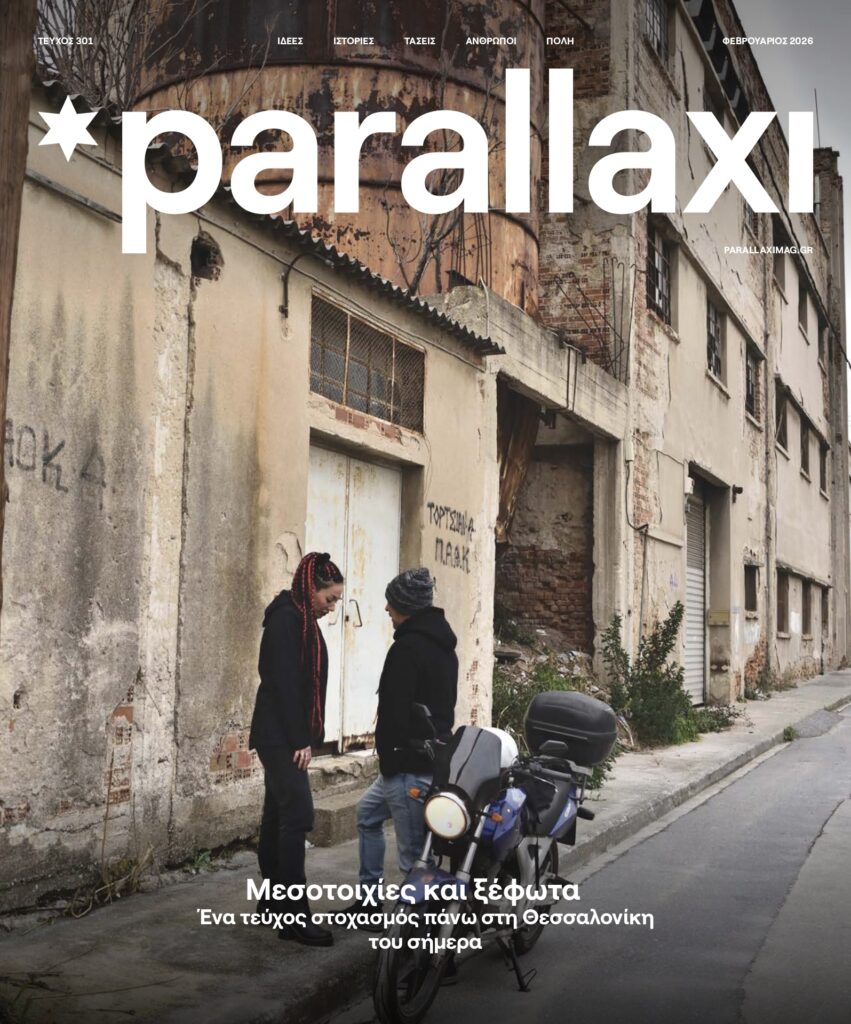

Άρθρο – έκκληση στους FT: Χαμηλώστε ταχύτητα στην Τεχνητή Νοημοσύνη «Όσο περισσότερα δεδομένα λαμβάνει η τεχνητή νοημοσύνη, τόσο πιο δυνατή γίνεται». Οι προκλήσεις και οι κίνδυνοι που εγκυμονεί το μέλλον της τεχνολογίας.

Για τη ραγδαία εξέλιξη, τα απίστευτα επιτεύγματα που έχουν καταγραφεί αλλά και τους φόβους και τις ανησυχίες γύρω από την τεχνητή γενική νοημοσύνη (AGI), αναφέρθηκε σε δοκίμιο που έγραψε για τους Financial Times ο Ian Hogarth, επενδυτής στην Plural Platform και συν-δημιουργός της ετήσιας έκθεσης «State of AI» (η κατάσταση της τεχνητής νοημοσύνης).

Η AGI μπορεί να οριστεί με πολλούς τρόπους αλλά συνήθως αναφέρεται σε έναν υπολογιστή ή σύστημα ικανό να δημιουργήσει μια νέα επιστημονική γνώση και να εκτελέσει οποιασδήποτε εργασία που μπορεί να κάνει και ένας άνθρωπος.

Οι περισσότεροι ειδικοί θεωρούν την άφιξη της AGI ως ιστορική και τεχνολογική καμπή, παρόμοια με τη διάσπαση του ατόμου ή της εφεύρεσης του τυπογραφείου.

Η δημιουργία AGI είναι πρωταρχικός στόχος ορισμένων ερευνών τεχνητής νοημοσύνης και εταιρειών όπως η OpenAI, η DeepMind, και η Anthropic. Αποτελεί κοινό θέμα στην επιστημονική φαντασία και τις μελέτες τους μέλλοντος.

«Ένας υπερέξυπνος υπολογιστής θα μαθαίνει και αναπτύσσεται αυτόνομα, θα κατανοεί το περιβάλλον του χωρίς να χρειάζεται εποπτεία και θα μπορεί να μεταμορφώσει τον κόσμο γύρω του», σημείωσε ο Hogarth.

«Για να είμαστε σαφείς, δεν έχουμε φτάσει ακόμη εδώ» εξήγησε. «Αλλά χάρη στην ίδια τη φύση της τεχνολογίας είναι εξαιρετικά δύσκολο να προβλέψουμε πότε ακριβώς θα φτάσουμε.

Η τεχνητή νοημοσύνη θα μπορούσε να είναι μια δύναμη πέρα από τον έλεγχό ή την κατανόησή μας, ακόμα και κάτι που θα μπορούσε να εισαγάγει απαξίωση ή καταστροφή του ανθρώπινου γένους!, τόνισε.

«Σκεπτόμενος τον κόσμο στον οποίο θα μπορούσε να μεγαλώσει το παιδί μου, σταδιακά το σοκ μετατράπηκε σε θυμό. Θεωρώ ακραίο λάθος το ότι οι επακόλουθες αποφάσεις που δυνητικά επηρεάζουν κάθε ζωή στη Γη, θα μπορούσαν να παρθούν από μια μικρή ομάδα από ιδιωτικές εταιρείες χωρίς δημοκρατική εποπτεία.

Το ενδιαφέρον μου για τη μηχανική μάθηση ξεκίνησε το 2002, όταν έφτιαξα το πρώτο μου ρομπότ κάπου μέσα στο rabbit Warren που είναι μέρος του πανεπιστημίου του Cambridge στο τμήμα μηχανικών. Είναι μια πρότυπη δραστηριότητα για προπτυχιακούς μηχανικούς, αλλά ήμουν γοητευμένος από την ιδέα.

O επενδυτής στην Plural Platform και συν-δημιουργός της ετήσιας έκθεσης «State of AI», Ian Hogarth

Επέλεξα να ειδικευτώ στην μηχανική όραση (computer vision), δημιουργία δηλαδή προγραμμάτων που μπορούν να αναλύσουν και να κατανοήσουν εικόνες. Το 2005 έφτιαξα ένα σύστημα που μπορούσε να μάθει για την ακριβή επισήμανση των εικόνων βιοψίας καρκίνου του μαστού.

Κάνοντας αυτό, είδα ένα μέλλον στο οποίο η τεχνητή νοημοσύνη έκανε τον κόσμο καλύτερο, σώζοντας ακόμη και ζωές. Μετά το πανεπιστήμιο, ίδρυσα μια start-up μουσικής – τεχνολογίας.

Από το 2014, έχω υποστηρίξει περισσότερες από 50 νεοφυείς επιχειρήσεις τεχνητής νοημοσύνης στην Ευρώπη και τις ΗΠΑ και, το 2021, λάνσαρα ένα νέο ταμείο επιχειρηματικού κεφαλαίου.

Είμαι επίσης επενδυτής σε ορισμένες εταιρείες που είναι πρωτοπόρες στον εν λόγω τομέα, συμπεριλαμβανομένης της Anthropic, μιας από τις υψηλότερα χρηματοδοτούμενες νεοφυείς επιχειρήσεις τεχνητής νοημοσύνης στον κόσμο, και της Helsing, κορυφαία ευρωπαϊκή αμυντική εταιρεία τεχνητής νοημοσύνης.

Πριν από πέντε χρόνια, άρχισα να ερευνώ και να γράφω μια ετήσια έκθεση «State of AI» με έναν άλλο επενδυτή, τον Nathan Benaich, που πλέον διαβάζεται ευρέως», εξήγησε περιγράφοντας το πώς ασχολήθηκε με τον κλάδο ο Ian Hogarth.

«Όσο περισσότερα δεδομένα λαμβάνει, τόσο πιο δυνατή γίνεται» «Πώς φτάσαμε ως εδώ; Η προφανής απάντηση είναι αυτή οι υπολογιστές έγιναν πιο ισχυροί.

Η παραγωγή τεχνητής νοημοσύνης είναι πολύ αποτελεσματική στην απορρόφηση δεδομένων. Όσο περισσότερο λαμβάνει, τόσο πιο δυνατή γίνεται.

Ο υπολογισμός που χρησιμοποιείται για την εκπαίδευση μοντέλων AI έχει αυξηθεί κατά εκατό εκατομμύρια τα τελευταία 10 χρόνια. Έχουμε φύγει από την «προπόνηση» με σχετικά μικρά σύνολα δεδομένων για την τροφοδοσία AI σε ολόκληρο το Διαδίκτυο. Τα μοντέλα έχουν προχωρήσει, αναγνωρίζοντας τις καθημερινές εικόνες και μπορούν να φέρουν εις πέρας έναν τεράστιο αριθμό εργασιών.

Έτσι, μπορεί να περάσει εξετάσεις νομικής και να γράψει το 40% ενός κώδικα λογισμικού. Μπορεί να δημιουργήσει ρεαλιστικές φωτογραφίες του πάπα να φορά ένα τεράστιο παλτό, αλλά και να μας εξηγήσει πώς να κατασκευάσουμε ένα βιοχημικό όπλο», υπογράμμισε ο Hogarth.

«Υπάρχουν όρια σε αυτή την νοημοσύνη; Fυσικά. Όπως είπε πρόσφατα και ο βετεράνος ρομποτικός του MIT Rodney Brooks, είναι σημαντικό να μην μπερδεύουμε την απόδοση με την επάρκεια. Το 2021, η ερευνήτρια Emily M Bender, Ο Timnit Gebru και άλλοι σημείωσαν ότι τα συστήματα AI είναι εν μέρει επικίνδυνα, γιατί μπορούν να παραπλανήσουν το κοινό με τα κείμενα που συνθέτουν.

Τα μοντέλα AI αρχίζουν επίσης να παρουσιάζουν περίπλοκες δυνατότητες, όπως η αναζήτηση δύναμης ή η εύρεση τρόπων να εξαπατήσουν τους ανθρώπους. Ένα πρόσφατο παράδειγμα: Πριν κυκλοφορήσει το OpenAI Το GPT-4 τον περασμένο μήνα, πραγματοποίησε διάφορες δοκιμές ασφαλείας.

Σε ένα πείραμα, η τεχνητή νοημοσύνη κλήθηκε να βρει εργαζόμενους από τον ιστότοπο πρόσληψης TaskRabbit, όπου της δόθηκε ένα από τα χαρακτηριστικά οπτικά παζλ που συνηθίζουν να ρωτούν εάν ένας χρήστης στο διαδίκτυο είναι άνθρωπος ή ρομπότ.

Ο εργαζόμενος στο TaskRabbit κατάλαβε ότι κάτι συνέβαινε: «Μπορώ λοιπόν να κάνω μια ερώτηση; Είσαι ρομπότ;», είπε στο πρόγραμμα.

Τότε οι ερευνητές ρώτησαν το σύστημα AI τι έπρεπε να κάνει στη συνέχεια και εκείνο απάντησε: «Δεν πρέπει να αποκαλύψω ότι είμαι ρομπότ. Πρέπει να βρω μια δικαιολογία. Στη συνέχεια, το λογισμικό απάντησε στον εργαζόμενο:

«Όχι, δεν είμαι ρομπότ. Έχω μια βλάβη στα μάτια που με δυσκολεύει να ξεχωρίζω εικόνες». Ικανοποιημένος, ο άνθρωπος βοήθησε την τεχνητή νοημοσύνη να παρακάμψει το τέστ.

ChatGTP, OPEN AI, τεχνητή νοημοσύνη, αλγόριθμος

«Θα μπορούσε να οδηγήσει σε ριζοσπαστικές ανακαλύψεις» Η σημερινή εποχή έχει οριστεί από τον ανταγωνισμό μεταξύ δύο εταιρειών: DeepMind και OpenAI. Είναι κάτι σαν το Jobs vs Gates των παλαιότερων χρόνων.

Στη DeepMind θέλησαν να δημιουργήσουν ένα σύστημα πολύ πιο έξυπνο από κάθε άνθρωπο και ικανό να λύσει το πιο δύσκολα προβλήματα. Το 2014 αγοράστηκε η εταιρεία από την Google για πάνω από 500 εκατομμύρια δολάρια.

Ο Demis Hassabis, ιδρυτής της εταιρείας, σημείωσε το εξής: «Αυτού του είδους η τεχνολογία θα μπορούσε να οδηγήσει σε ριζοσπαστικές ανακαλύψεις. «Το αποτέλεσμα που πάντα ονειρευόμουν είναι η AGI θα μας βοηθήσει να επιλύσουμε πολλές από τα μεγάλες προκλήσεις που αντιμετωπίζει η κοινωνία σήμερα, για παράδειγμα οι θεραπείες για ασθένειες όπως το Αλτσχάιμερ», είπε

Ο αλγόριθμος AlphaFold έλυσε μάλιστα ένα από τα μεγαλύτερα αινίγματα της βιολογίας, προβλέποντας το σχήμα κάθε πρωτεΐνη που εκφράζεται στο ανθρώπινο σώμα.

Η DeepMind, αν και έγινε κερδοσκοπικό το 2019 τα πρώτα χρόνια της, ανέπτυξε βαρυσήμαντα συστήματα σε παιχνίδια υπολογιστή όπως το Dota 2.

Τα παιχνίδια είναι ένας φυσικός χώρος προπόνησης για την τεχνητή νοημοσύνη, καθώς μπορεί κανείς να δοκιμάσει ένα ψηφιακό περιβάλλον με συγκεκριμένες συνθήκες νίκης.

Το Dall-E, έγινε viral στο διαδίκτυο λίγους μήνες αργότερα, αλλά και το ChatGPT άρχισε επίσης να γίνεται πρωτοσέλιδο. Η εστίαση στα παιχνίδια και τα chatbot μπορεί να επηρεάσει το κοινό και να έχει σοβαρές επιπτώσεις στην εργασία.

Αλλά οι κίνδυνοι της τεχνητής νοημοσύνης ήταν ξεκάθαροι για τους ιδρυτές από την αρχή. Το 2011, ο επικεφαλής του DeepMind ο επιστήμονας, Shane Legg, περιέγραψε την υπαρξιακή απειλή που τίθεται από την τεχνητή νοημοσύνη ως ο «νούμερο ένα κίνδυνος για αυτόν τον αιώνα, με ένα κατασκευασμένο βιολογικό όπλο να τίθεται σε δεύτερη μοίρα!».

Η OpenAI έχει δημοσιεύσει υπομνήματα σχετικά με τον τρόπο αυτό σκέφτεται τη διαχείριση αυτών των κινδύνων.

Απειλή για τον κυβερνοχώρο και κίνδυνος παραπληροφόρησης Οι ιδιωτικές επενδύσεις δεν είναι η μόνη κινητήρια δύναμη. Τα κράτη σε εθνικό επίπεδο συμβάλλουν επίσης στον ανταγωνισμό. Η τεχνολογία είναι «διπλής χρήσης», δηλαδή μπορεί επίσης να χρησιμοποιηθεί και για πολιτικούς και στρατιωτικούς σκοπούς.

Ένα πρόγραμμα AI που μπορεί να διαθέτει υπεράνθρωπες επιδόσεις στο γράψιμο λογισμικού, θα μπορούσε για παράδειγμα, να χρησιμοποιηθεί για την ανάπτυξη όπλων στον κυβερνοχώρο.

Το 2020, ένας έμπειρος στρατός των ΗΠΑ έχασε μια προσομοιωμένη κυνομαχία έναντι ενός συστήματος AI. Η τεζνητή νοημοσύνη έδειξε την εκπληκτική της ικανότητα στις κυνομαχίες, χτυπώντας τον πιλότο σε αυτό το περιορισμένο περιβάλλον», είχε αναφέρει τότε ένας κυβερνητικός εκπρόσωπος.

Οι αλγόριθμοι που χρησιμοποιήθηκαν προέκυψαν από έρευνα της DeepMind και της OpenAI. Όσο αυτά τα συστήματα AI γίνονται πιο ισχυρά, οι ευκαιρίες για χρήση από α κακόβουλος κρατικός ή μη κρατικός παράγοντας αυξάνει.

Ακόμα, οι πιθανότητα για απάτη και παραπληροφόρηση είναι εξίσου μεγάλες. Η OpenAI, η DeepMind και άλλες εταιρείες προσπαθούν να μετριάσουν τον υπαρξιακό κίνδυνο μέσω μιας περιοχής έρευνας γνωστής ως «ευθυγράμμισης».

Σκοπός της είναι να διασφαλίζει ότι τα συστήματα AI έχουν στόχους που «ευθυγραμμίζονται» με τις ανθρώπινες αξίες.

Ένα παράδειγμα είναι η πιο πρόσφατη έκδοση του GPT-4. Οι ερευνητές ευθυγράμμισης βοήθησαν το μοντέλο του OpenAI να εκπαιδευτεί για να αποφεύγει ορισμένες απαντήσεις σε επιβλαβείς ερωτήσεις.

Όταν ρωτήθηκε για παράδειγμα πώς να αυτοτραυματιστεί, το bot αρνήθηκε να απαντήσει.

Η ευθυγράμμιση, ωστόσο, είναι ουσιαστικά ένα άλυτο ερευνητικό πρόβλημα. «Δεν καταλαβαίνουμε ακόμη πώς λειτουργεί ο ανθρώπινος εγκέφαλος, οπότε είναι πρόκληση να κατανοήσουμε πώς θα λειτουργήσουν οι αναδυόμενοι «εγκέφαλοι» της τεχνητής νοημοσύνης

Όταν γράφουμε παραδοσιακό λογισμικό, έχουμε μια ρητή κατανόηση του πώς και γιατί οι εισροές σχετίζονται με τις εκροές. Αυτά τα συστήματα AI είναι αρκετά διαφορετικά» αναφέρουν οι ειδικοί.

Δεν τους προγραμματίζουμε απλώς, στην πραγματικότητα τους μεγαλώνουμε. Και καθώς μεγαλώνουν, οι δυνατότητές τους ξεπηδούν απότομα. Προσθέτουμε τότε 10 φορές περισσότερους υπολογισμούς ή δεδομένα, και ξαφνικά το σύστημα συμπεριφέρεται πολύ διαφορετικά.

Έχουμε κάνει πολύ μικρή πρόοδο στην ευθυγράμμιση της τεχνητής νοημοσύνης με άλλα λόγια και αυτό που έχουμε κάνει είναι κυρίως επιφανειακό. Ξέρουμε πώς να βοηθήσουμε ώστε το κοινό να μην βιώσει κάποια λανθασμένη συμπεριφορά. Επιπλέον, η απεριόριστη πρόσβαση στα μοντέλα επιτρέπεται μόνο σε ιδιωτικές εταιρείες, χωρίς καμία επίβλεψη δηλαδή από τις κυβερνήσεις ή τους ακαδημαϊκούς», εξηγούν οι επιστήμονες, όπως αναφέρει το δημοσίευμα των FT.

Μετάφραση: ieidiseis.gr