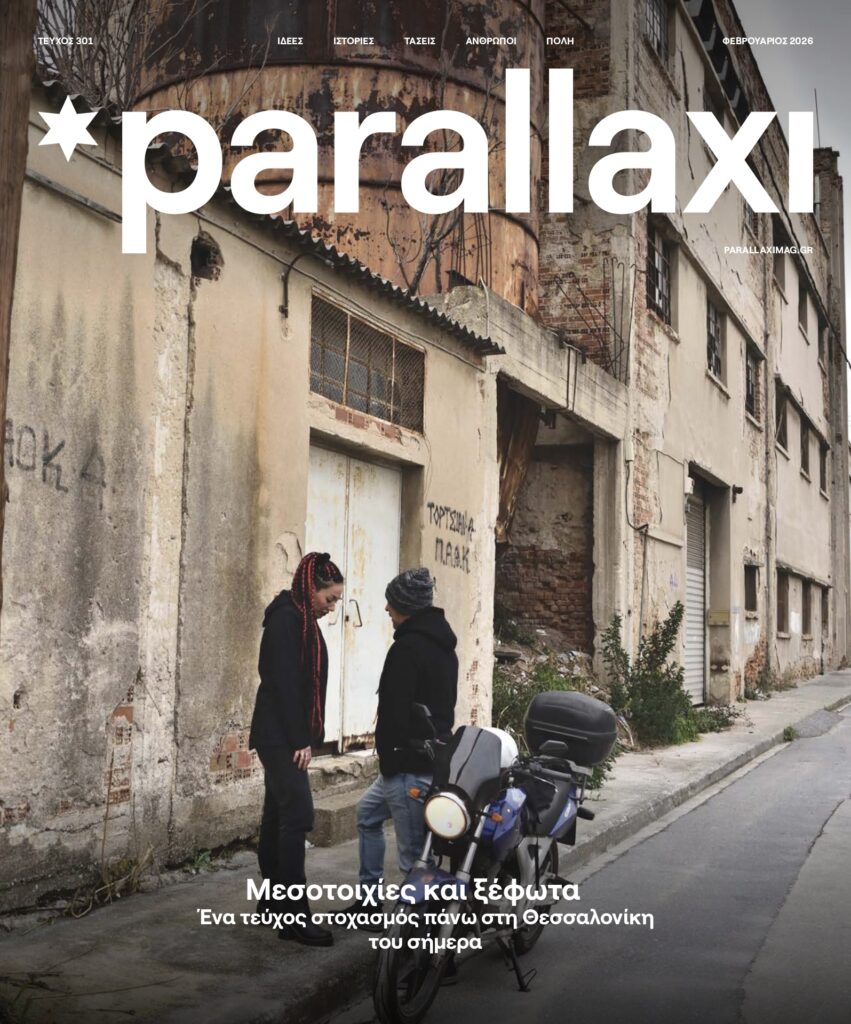

Τεχνητή νοημοσύνη: Χρησιμοποιούν οικείες φωνές και εξαπατούν ανυποψίαστους πολίτες

Ένα παλιό κόλπο με τη χρήση νέας τεχνολογίας.

Το in.gr δημοσιεύει σήμερα κείμενο με την υπογραφή του Γιώργου Γεωρτζόγλου και σε αυτό αναφέρει ότι κάποιοι χρησιμοποιούν την τεχνητή νοημοσύνη και οικείες φωνές προκειμένου να εξαπατήσουν ανυποψίαστους πολίτες.

Διαβάστε αναλυτικότερα παρακάτω όσα αναφέρει το σχετικό ρεπορτάζ:

Κλήσεις εξαπάτησης χρησιμοποιούν τη γενετική τεχνητή νοημοσύνη, η οποία αναφέρεται σε συστήματα ικανά να δημιουργούν κείμενο, εικόνες ή οποιοδήποτε άλλο μέσο, όπως βίντεο, με βάση τις εντολές ενός χρήστη (φωτογραφία, επάνω, από το Reuters).

Πολύκροτα περιστατικά

Τα deepfakes έχουν αποκτήσει την κακόβουλη φήμη τους τα τελευταία χρόνια με μια σειρά από πολύκροτα περιστατικά, όπως η απεικόνιση της αγγλίδας ηθοποιού Εμα Γουάτσον που χρησιμοποιήθηκε σε μια σειρά από σεξουαλικές διαφημίσεις στο Facebook και στο Instagram.

Υπήρξε επίσης το ευρέως μοιρασμένο – και διαψευσμένο – βίντεο από το 2022 στο οποίο ο πρόεδρος της Ουκρανίας Βολοντίμιρ Ζελένσκι φαινόταν να ζητά από τους Ουκρανούς «να καταθέσουν τα όπλα» (φωτογραφία, επάνω και βίντεο, κάτω).

Τώρα, η τεχνολογία για τη δημιουργία ήχου deepfake, ενός ρεαλιστικού αντιγράφου της φωνής κάποιου ατόμου, γίνεται ολοένα και πιο κοινή.

Για να δημιουργήσετε ένα ρεαλιστικό αντίγραφό της χρειάζεστε δεδομένα προκειμένου να εκπαιδεύσετε τον αλγόριθμο. Αυτό σημαίνει ότι έχετε πολλές ηχογραφήσεις της φωνής του στόχου σας, γράφει σε ανάλυσή του ο Oliver Buckley.

«Σε κάνει» να πεις ό,τι θέλει

Με όσο περισσότερα δείγματα μπορέσετε να τροφοδοτήσετε τους αλγόριθμους, τόσο καλύτερο και πιο πειστικό θα είναι το τελικό αντίγραφο.

Πολλοί από εμάς μοιραζόμαστε ήδη λεπτομέρειες της καθημερινότητάς μας στο Διαδίκτυο. Αυτό σημαίνει ότι τα δεδομένα ήχου που απαιτούνται για τη δημιουργία ενός ρεαλιστικού αντιγράφου μιας φωνής θα μπορούσαν να είναι άμεσα διαθέσιμα στα μέσα κοινωνικής δικτύωσης.

Αλλά τι συμβαίνει όταν ένα αντίγραφο βρίσκεται εκεί έξω; Ποιο είναι το χειρότερο που μπορεί να συμβεί; Ενας αλγόριθμος deepfake θα μπορούσε να επιτρέψει σε οποιονδήποτε έχει τα δεδομένα να «σε κάνει» να πεις ό,τι θέλει.

Στην πράξη, μπορεί να είναι τόσο απλό όσο να γράψετε κάποιο κείμενο και να ζητήσετε από τον υπολογιστή να το διαβάσει δυνατά.

Μείζονες προκλήσεις

Αυτή η δυνατότητα ενέχει τον κίνδυνο εξάπλωσης της ηχητικής και γενικής παραπληροφόρησης. Μπορεί να χρησιμοποιηθεί σε προσπάθειες επηρεασμού της διεθνούς ή της εθνικής κοινής γνώμης, όπως φαίνεται στα «βίντεο» του Ζελένσκι.

Ωστόσο, η πανταχού παρουσία και η διαθεσιμότητα αυτών των τεχνολογιών θέτει σημαντικές προκλήσεις και σε τοπικό επίπεδο – ιδιαίτερα στην αυξανόμενη τάση των κλήσεων απάτης με τεχνητή νοημοσύνη.

Πολλοί άνθρωποι θα έχουν εξαπατηθεί ή θα έχουν δεχθεί phishing (ηλεκτρονικό «ψάρεμα») που μας λέει, για παράδειγμα, ότι ο υπολογιστής μας έχει παραβιαστεί και πρέπει να συνδεθούμε αμέσως, δίνοντας στον καλούντα πρόσβαση στα δεδομένα μας.

Συχνά είναι πολύ εύκολο να εξακριβωθεί ότι πρόκειται για φάρσα, ειδικά όταν ο καλών διατυπώνει αιτήματα που δεν θα έκανε ο εκπρόσωπος ενός νόμιμου οργανισμού.

Η κόρη της ζητούσε λύτρα…

Ωστόσο, φανταστείτε τώρα ότι η φωνή στην άλλη άκρη του τηλεφώνου δεν είναι απλώς ένας άγνωστος, αλλά ακούγεται ακριβώς σαν ένας φίλος ή σαν ένα αγαπημένο πρόσωπο. Αυτό διαμορφώνει ένα εντελώς νέο επίπεδο πολυπλοκότητας και προκαλεί πανικό στον άτυχο αποδέκτη.

Ρεπορτάζ του CNN επισημαίνει ένα περιστατικό κατά το οποίο μια μητέρα έλαβε κλήση από άγνωστο αριθμό. Οταν απάντησε στο τηλέφωνο, ήταν η κόρη της. Φερόταν να είχε απαχθεί και τηλεφωνούσε για να ζητήσει λύτρα. Το κορίτσι βέβαια ήταν σώο και αβλαβές. Οι απατεώνες είχαν κάνει deepfake τη φωνή του.

Αυτό δεν είναι ένα μεμονωμένο περιστατικό, και υπάρχουν διάφορες παραλλαγές, όπως του υποτιθέμενου τροχαίου ατυχήματος, με το θύμα να καλεί την οικογένειά του ζητώντας χρήματα για να το βοηθήσουν.

Παλιό κόλπο με νέα τεχνολογία

Δεν πρόκειται, βέβαια, για μια νέα απάτη από μόνη της. Ο όρος «εικονική απάτη απαγωγής» υπάρχει εδώ και αρκετά χρόνια.

Μπορεί να πάρει πολλές μορφές, αλλά μια κοινή προσέγγιση είναι η εξαπάτηση των θυμάτων ώστε να καταβάλουν λύτρα προκειμένου να ελευθερωθεί ένα αγαπημένο τους πρόσωπο που πιστεύουν ότι απειλείται.

Ο απατεώνας προσπαθεί να πετύχει την άμεση τυφλή υποταγή προκειμένου να πείσει το θύμα να πληρώσει γρήγορα τα λύτρα πριν αποκαλυφθεί η εξαπάτηση.

Η ανάδυση των ισχυρών και διαθέσιμων τεχνολογιών τεχνητής νοημοσύνης έχει αυξήσει σημαντικά τη σοβαρότητα των περιστατικών – και έχει κάνει τα πράγματα πιο προσωπικά.

Μπορεί να κλείσετε το τηλέφωνο σ’ έναν ανώνυμο, αλλά απαιτείται πραγματική εμπιστοσύνη στην κρίση σας για να διακόψετε μια κλήση με κάποιον που ακούγεται ακριβώς σαν το παιδί ή τον σύντροφό σας.

Δυνατότητα αναγνώρισης

Υπάρχει λογισμικό που μπορεί να χρησιμοποιηθεί για την αναγνώριση των deepfakes και δημιουργεί μια οπτική αναπαράσταση του ήχου που ονομάζεται φασματογράφημα.

Οταν ακούτε την κλήση, ίσως να φαίνεται αδύνατο να την ξεχωρίσετε από το πραγματικό πρόσωπο, αλλά οι φωνές μπορούν να διακριθούν όταν τα φασματογραφήματα αναλύονται δίπλα-δίπλα.

Τουλάχιστον μία ομάδα έχει προσφέρει λογισμικό ανίχνευσης για λήψη, αν και τέτοιες λύσεις ενδέχεται ν’ απαιτούν ακόμα ορισμένες τεχνικές γνώσεις από τον χρήστη.

Οι περισσότεροι άνθρωποι δεν θα μπορούν να δημιουργήσουν φασματογραφήματα, οπότε τι μπορείτε να κάνετε όταν δεν είστε σίγουροι πως αυτό που ακούτε είναι το πραγματικό; Οπως με κάθε άλλη μορφή μέσων επικοινωνίας μπορείτε να είστε δύσπιστοι.

Εάν λάβετε μια κλήση από ένα αγαπημένο σας πρόσωπο ξαφνικά και σας ζητήσει χρήματα ή σας διατυπώσει αιτήματα που φαίνονται ξένα προς τον χαρακτήρα του, καλέστε το ή στείλτε του ένα μήνυμα για να επιβεβαιώσετε ότι πράγματι του μιλάτε.

Καθώς οι δυνατότητες της τεχνητής νοημοσύνης επεκτείνονται, οι γραμμές μεταξύ πραγματικότητας και φαντασίας θα θολώνουν όλο και περισσότερο.

Και δεν είναι πιθανό ότι θα μπορέσουμε να επαναφέρουμε την τεχνολογία πίσω στο κουτί. Αυτό σημαίνει ότι οι άνθρωποι θα πρέπει να γίνουν πιο προσεκτικοί.

Πηγή: Γιώργος Γεωρτζόγλου/ in.gr